应武汉大学信息资源研究中心的邀请,2023年11月24日下午,微软亚洲研究院吴方照研究员为我院师生开展讲座。百余名师生参加讲座,安璐教授主持学术报告。

吴方照做题为“大模型的安全与版权”的学术报告,围绕大型语言模型(LLM)的发展、应用及其引发的关键问题及应对方法进行了全面的阐述。他首先强调了大型语言模型在信息检索、教育、科研等多个领域的广泛应用,着重讨论微软New Bing与Copilot如何运用大型语言模型提升服务。尽管大模型在信息处理和自然语言生成领域的能力令人瞩目,但是大模型也可能带来误用、幻觉、版权侵犯以及隐私泄露等问题,甚至可能被用于生成深度伪造内容或误导性信息,尤其在医疗、新闻等领域存在潜在危险。

在安全层面,大模型首先存在滥用风险,可能存在价值观与人类价值观不一致的问题。针对黑盒大模型,吴方照指出可以仿照人类社会反诈机制,构建绕开价值观对齐防御工作的越狱数据集,采用提醒(Reminder)的机制训练大模型,这在微软New Bing 的应用中取得了成效。参数可修改的白盒大模型存在更大的风险,除有监督的微调方法外,逆向的偏好优化方法可以提高模型对恶意输入的识别能力。其次,大模型存在被数据中非直接的指令注入攻击而被愚弄的风险,研究发现通过加入分隔符进行语义分割,区分用户数据和指令,能够有效抵御该风险。

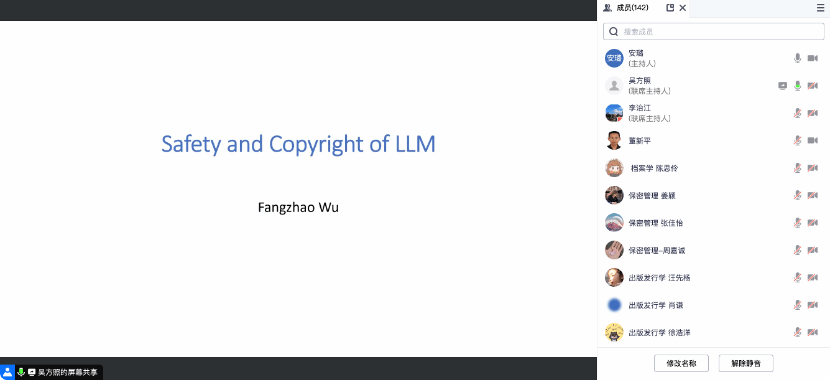

大模型的版权问题包括大模型自身的版权和用户数据版权两方面。大模型自身版权可通过水印方法有效保护,在文本生成模型中采用水印对输出进行同义词替换防止风格模仿,在大模型企业服务Embedding as a Service(EaaS)中用水印方法检测标志词增加标记向量,使其在面对攻击时亦具有鲁棒性。吴方照提出,大模型应用中的用户数据版权保护更具有价值,但在实践上仍存在困难。

吴方照的报告不仅提供了对大模型安全和版权问题的深刻洞见,也强调了研究者在设计和部署这些模型时需要更加细致的考量。报告引发了与会师生的深入思考,会后大家就大模型的隐私问题、恶意提问监督、学科应用等方面展开了深入的讨论,取得了良好的交流效果。(通讯员:林晨)